探码Dyson,浅谈数据采集要点!

作者:探码科技, 原文链接: http://www.tanmer.com/Big-DB/433

说起大数据大家都不陌生,但何为数据采集,数据分析很多人都不够明白,本文将从数据采集的三大要点、四大步骤分展开聊,为大家解析数据采集。后面将会为大家带来采集工具的分享!

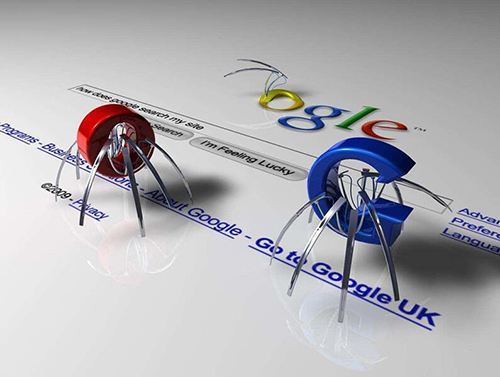

数据采集

数据采集就是对互联网网页的数据(图片、文字、链接)进行爬虫抓取,把这些数据进行汇总。并按照一定规则和筛选标准进行数据归类形成数据库文件的一个过程。但在这个过程中,我们首先需要明确我们要采集的信息是什么,当你将采集的条件收集的足够精确时,那么采集的内容就越接近你想要的。

数据采集的网站大都是公开的,这类网站采集的难度较小。还有一些特殊的网站只有登录成功后才能展示详细的信息,像付费的企业查询类的天眼查之类的,为了保护数据防止爬虫采集都是上了手段的,这类网站的采集难度较大。

下面探码Dyson将为你讲解,高质量的数据采集中需要遵循三大要点和四大步骤!

数据采集的三大要点

1. 采集的全面性

采集的数据量足够大具有分析价值、数据面足够支撑分析需求。比如查看app的使用情况这一行为,我们需要采集从用户触发时的环境信息、会话、以及背后的用户id,最后需要统计这一行为在某一时段触发的人数、次数、人均次数、活跃比等。

2. 采集的多维性

数据更重要的是能满足分析需求。灵活、快速自定义数据的多种属性和不同类型,从而满足不同的分析目标。比如“查看app的使用情况”这一行为,我们需要采集用户使用的app的哪些功能、点击频率、使用时常、打的app的时间间隔等多个属性。才能使采集的结果满足我们的数据分析!

3. 采集的高效性

高效性包含技术执行的高效性、团队内部成员协同的高效性以及数据分析需求和目标实现的高效性。

数据采集的四大步骤

- 明确数据需求:数据需求的明确细化是数据采集的重中之重,如果我们的需求混淆不清那采集到的资源会变的量大不精。比如我要采集淘宝上所有牛奶商品的信息和评价。越明确和细致的采集需求越容易解决问题。数据采集公司最无法接受的就是那种:我想要市面上所有在做招投标信息发布企业的名称项目,搞笑呢现在主流的搜索引擎都无法做到如此强大的功能,你让我们这些数据采集商,去哪里给你采集全去。对于这种的需求,我们只能说:您呐出门右拐不送了!

- 调研数据来源:客户有了需求了,我们就得研究去哪里采集,去什么网站,什么网页上采集才有我们想要的数据。然后锁定采集范围和对采集的数据量进行预估。这步最重要的是细化客户需求,研究采集方向!

- 确定用什么采集工具、软件、代码来采集网页上的:工具、软件等就是枪,代码和采集规则就是子弹可以进行多种组合。面对不同的网站我们只有选择更加合适的组合才能使采集结果更加有效。采集工具推荐:探码dyson数据采集系统!

- 确定存储的方式:我们采集的数据量有大有小,采集到的数据可能是几百上千,也可能是千万级或者亿万级的。这时我们需要根据采集量的大小对数据储存的方式进行划分。如果只有几万条数据,一般excel表格对付对付也就哦了,但是如果面对几千万的数据,怎么也得搞个数据库才能处理的过来。对于GB级别的数据,就得用Hadoop、Spark、Redis等分布式存储和处理技术的方法才能做到较好的管理和计算。正确数据存储的方式才能使了客户对数据的使用与管理更加便捷!

只有运用好的采集方法与步骤才能使数据价值最大化!