探码Web数据源采集分析系统

作者:探码科技, 原文链接: http://www.tanmer.com/web-bigdata/360

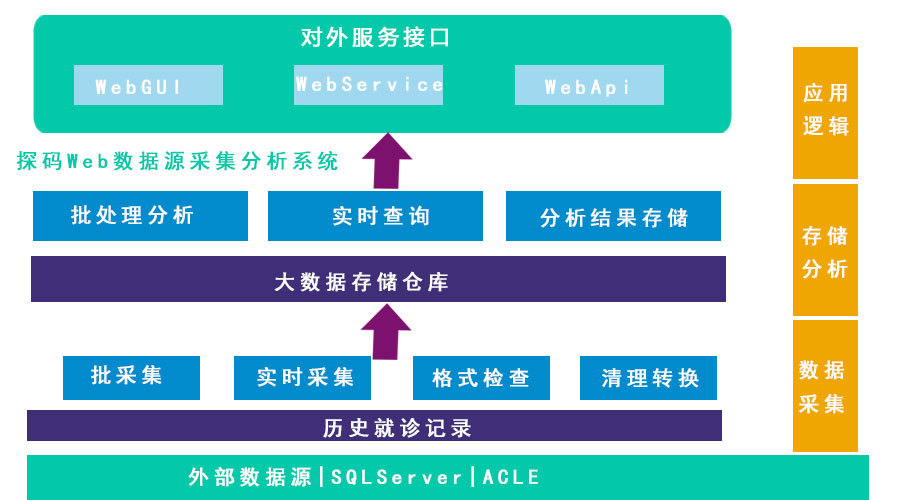

2017年,探码科技开发一个金融行业投融资交易大数据平台,在项目进行前期,需要对资料的搜集准备和数据源的整理,最后整理出来了很多需要采集的数据源,为了进一步落实数据源的数据量、是否有采集价值、采集价值有多大等一列问题,探码科技研发了一套探码Web数据源采集分析系统。

Web数据源采集分析要么对网站访客行为的分析,即包括:网站流量报告,也可能包括电子邮件回应率、直接邮件活动资料、销售与客户资料、使用者效能资料如点击热点地图、或者其他自订需求资讯等等,然后进行行为分析,最终形成网络数据报告,以此来了解和优化网站;要么是爬取整个网站数据源资料、栏目、项目等进行数据源的采集,然后进行分析形成信息数据报告,最终用在:产生潜在的客户列表;从竞争对手中收集企业所需信息;抓取新兴业务数据;建立企业的产品目录;整合行业信息,辅助经营决策;确定新客户,增加新订单;挖掘老客户,获取利益……总之,Web页面内容所显示的即可采集进行分析形成可视化为企业所用。

探码Web数据源采集分析系统主要采用Ruby on Rails + vue.js + Bootstrap实现数据源分析系统的后台和前端展示的搭建。根据各行业的需求可将整体分为多个模块多种形式进行可视化。其主要的步骤:1、从目标Web文档中获得待采集信息;2、判断待采集信息类型是否是所需数据,3、剔除无用的、重复的信息数据,按照所需信息数据进行过滤校验;4、保存所需数据。

探码Web数据源采集分析系统——采集

其特征是利用云计算服务器协同工作,能快速采集大量数据,而且也避免了一台计算机硬件资源的瓶颈,另外对数据采集的要求越来越高,传统post采集不能解决的技术问题也逐步被解决,以探码Kapow/Dyson采集器为代表的新一代智能采集器,能模拟人的思维,模拟人的操作,从而彻底解决了ajax等技术难题,因为网页一般都是设计来给人浏览的,所以能模拟人的智能采集器工作起来就非常顺利,不论后台技术是什么,当数据最终显示在人的面前的时候,智能采集器就开始提取。这最终把计算机的能力发挥到了极致,使得计算机可以代替人做所有网页数据采集的工作。同时利用大数据云采集技术,把计算机的计算能力也发挥到了极致。

探码Web数据源采集分析系统——分析

主要是通过对既有数据源进行分类整理、栏目划分、字段拆解,形成一个完整的数据源分析报告,以及对采集到的信息数据进行智能分析最终通过数据源的分析,发现数据之间的关系、规律和取值范围,为数据采用任务做准备。

探码Web数据源采集分析系统的优势:

1、全方位的采集

只要是Web页面可以看见的内容都可以采集,采集的内容数据包括文字、图片、flash动画、视频等各类内容;

2、可实现复杂的对象的采集

可实现正文和回复内容的同时采集,一级页面二级页面内容也可轻松实现合并,采集的内容可以是分散在多个页面内,结果可以是复杂的父子表结构;

3、采集速度比普通采集快

探码Web数据源采集分析系统采用前沿先进的技术,可运行多条线程同时抓取采集,采集速度比普通采集快上很多倍;

4、精准度高,覆盖面广

只要能在Web页面中可以看到的内容,几乎都可以按照需要的格式、所需信息数据进行采集。

5、数据可视化,结果输出多样化

采集的信息数据可采用探码TMDash可视化,呈现给企业,简单易读易懂。

互联网时代,先进的大数据,人工智能和深度学习等技术实现了互联网平台的数据接口,探码Web数据源采集分析系统能提供专业的数据采集服务,精准采集分析所需信息数据。

注:Web数据源采集系统的原理类似于搜索引擎的爬虫,是合法的。